Nền tảng Blackwell thế hệ tiếp theo của Nvidia sẽ được đưa vào Google Cloud vào đầu năm 2025

Trong tuần này tại sự kiện Google Cloud Next ở Las Vegas, đồng nghĩa với việc một loạt các loại máy ảo mới và các bộ tăng tốc mới sẽ xuất hiện trên Google Cloud Platform. Ngoài việc giới thiệu các vi xử lý Arm tùy chỉnh mới Axion, hầu hết các thông báo trong năm nay đều liên quan đến các bộ tăng tốc trí tuệ nhân tạo, có thể được xây dựng bởi Google hoặc từ Nvidia.

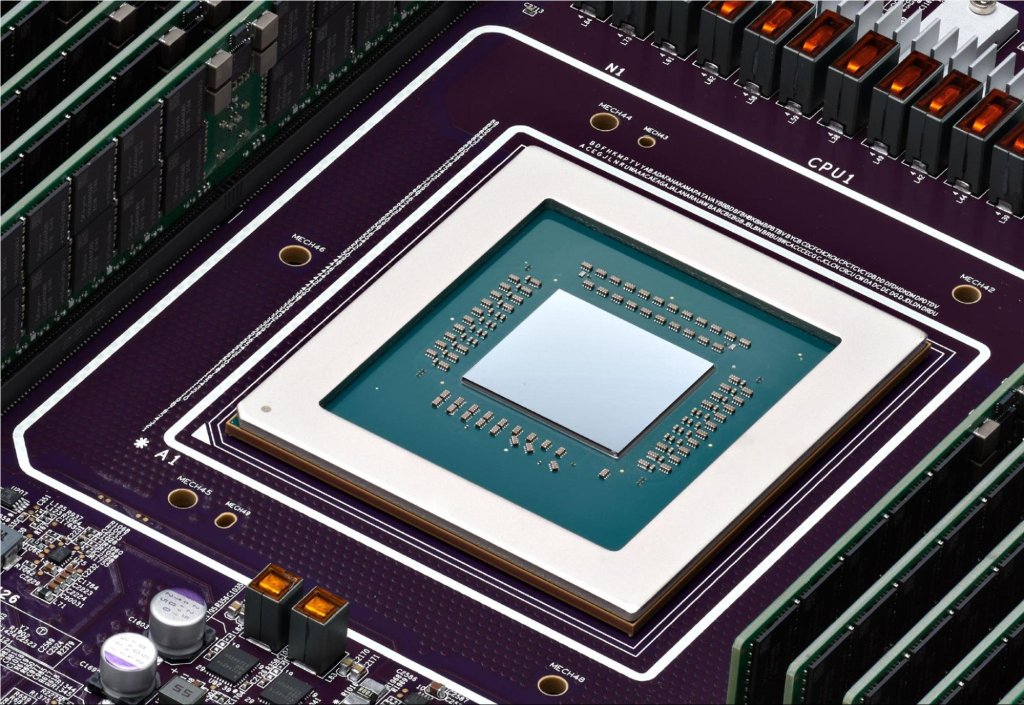

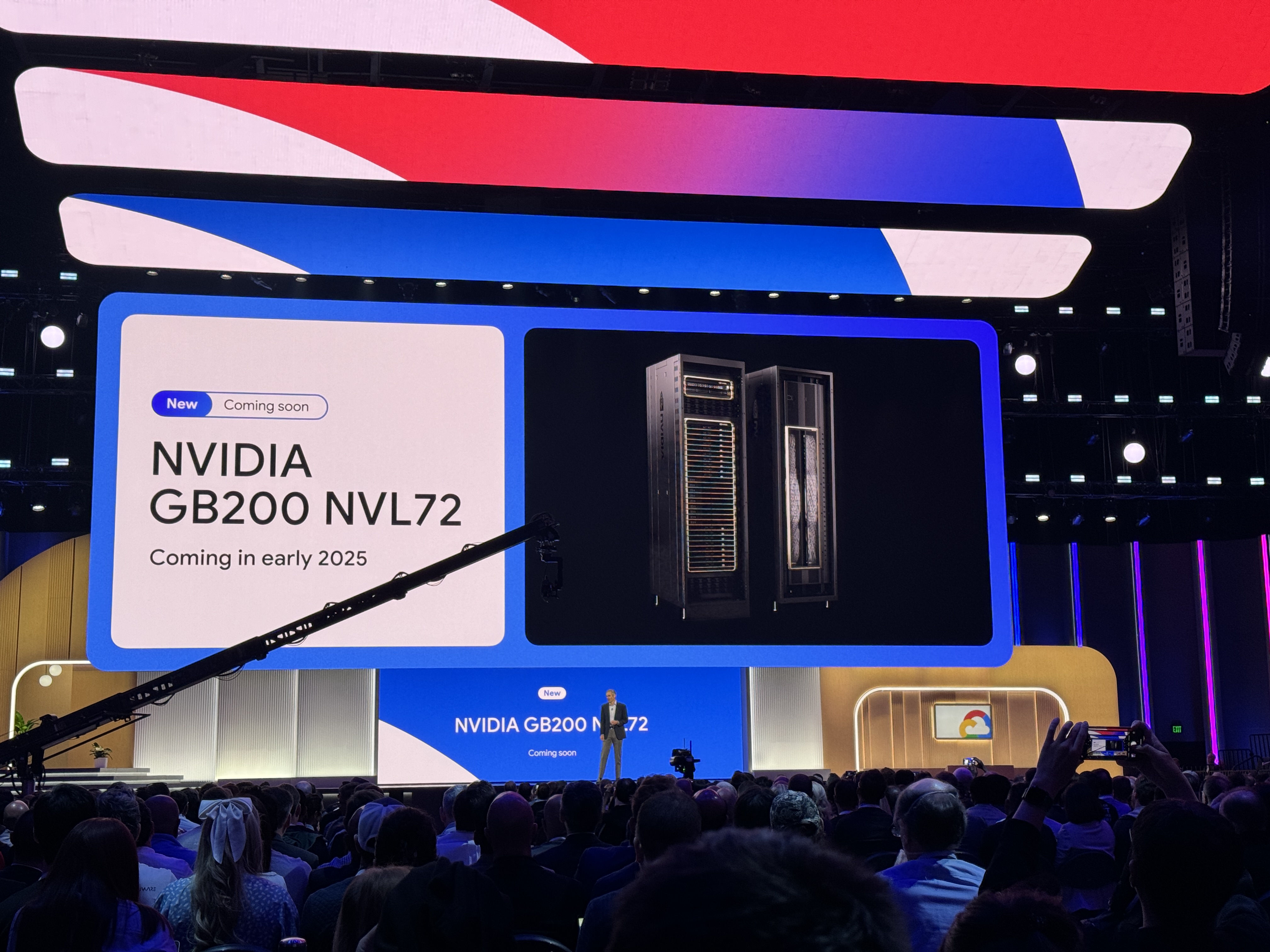

Chỉ vài tuần trước, Nvidia thông báo về nền tảng Blackwell của mình. Nhưng đừng mong chờ Google sẽ cung cấp các máy này trong thời gian sớm. Hỗ trợ cho các vi xử lý cao cấp Nvidia HGX B200 cho các công việc trí tuệ nhân tạo và HPC và GB200 NBL72 cho việc huấn luyện mô hình ngôn ngữ lớn sẽ đến vào đầu năm 2025. Một thông tin thú vị từ thông báo của Google: Các máy chủ GB200 sẽ được làm mát bằng chất lỏng.

Điều này có vẻ như một thông báo hơi sớm, nhưng Nvidia đã nói rằng các chip Blackwell của mình sẽ không được công khai cho đến quý cuối năm nay.

Trước Blackwell

Đối với các nhà phát triển cần nhiều công suất hơn để huấn luyện các mô hình ngôn ngữ lớn ngay bây giờ, Google cũng thông báo về loại máy ảo A3 Mega. Máy ảo này, mà công ty phát triển cùng với Nvidia, tích hợp các GPU H100 tiêu chuẩn ngành nhưng kết hợp chúng với hệ thống mạng mới có thể cung cấp tới gấp đôi băng thông trên mỗi GPU.

Một loại máy ảo A3 khác là A3 bảo mật, mà Google mô tả là cho phép khách hàng “bảo vệ tốt hơn tính bảo mật và tính toàn vẹn của dữ liệu nhạy cảm và công việc trí tuệ nhân tạo trong quá trình huấn luyện và suy diễn.” Công ty đã lâu mang lại dịch vụ tính toán bảo mật bằng cách mã hóa dữ liệu khi sử dụng, và ở đây, khi kích hoạt, tính toán bảo mật sẽ mã hóa quá trình truyền dữ liệu giữa CPU của Intel và GPU H100 của Nvidia thông qua PCIe bảo vệ. Không cần thay đổi mã, Google nói.

Đối với các vi xử lý của Google, công ty vào thứ Ba đã ra mắt bộ xử lý Cloud TPU v5p - loại mạnh mẽ nhất trong các bộ tăng tốc trí tuệ nhân tạo được phát triển bởi công ty, cho sẵn sàng sử dụng. Các chip này có cải tiến lên đến 2 lần về số phép tính hạng phẩy mỗi giây và cải tiến lên đến 3 lần về tốc độ băng thông của bộ nhớ.

Tất cả những chip nhanh đó cần một kiến trúc cơ sở có thể cạnh tranh với chúng. Vì vậy ngoài các chip mới, Google cũng thông báo vào thứ Ba về các lựa chọn lưu trữ được tối ưu hóa cho trí tuệ nhân tạo. Hyperdisk ML, hiện đang trong bản xem trước, là dịch vụ lưu trữ khối thế hệ tiếp theo của công ty có thể cải thiện thời gian tải mô hình lên đến 3,7 lần, theo Google.

Google Cloud cũng đang ra mắt một số máy ảo cổ điển hơn, được cung cấp bởi các vi xử lý Xeon thế hệ thứ tư và thứ năm của Intel. Ví dụ, các máy ảo chung C4 và N4 mới, ví dụ, sẽ tích hợp vi xử lý Xeon Emerald Rapids thế hệ thứ năm, với C4 tập trung vào hiệu suất và N4 tập trung vào giá cả. Các máy ảo C4 mới hiện đang trong bản xem trước, và các máy N4 đã sẵn sàng sử dụng ngay.

Một sản phẩm mới khác, nhưng vẫn đang trong bản xem trước, là các máy ảo gốc không gắn bộ (bare-metal) C3, được tích hợp bởi vi xử lý Xeon thế hệ thứ tư cũ hơn, các máy ảo gốc tối ưu hóa bộ nhớ X4 (cũng đang trong bản xem trước) và Z3, máy ảo ổn định lưu trữ tối ưu hóa đầu tiên của Google Cloud mà hứa hẹn cung cấp “các phép tính IOPS cao nhất cho các máy ảo tối ưu hóa lưu trữ giữa các đám mây hàng đầu.”

Diễn đàn NVIDIA tại Hội nghị GTC đã mang đến một số bất ngờ